各製品の資料を入手。

詳細はこちら →PolyBase で外部データソースとしてSpark を連携利用

CData ODBC ドライバとSQL Server 2019 のPolyBase を使って、リアルタイムSpark に外部データソースとしてアクセス。

最終更新日:2022-04-21

この記事で実現できるSpark 連携のシナリオ

こんにちは!ドライバー周りのヘルプドキュメントを担当している古川です。

SQL Server のPolyBase は、データベーステーブルをクエリするTransact-SQL 構文を使って、外部データにクエリする仕組みです。 CData ODBC Driver for SparkSQL を組み合わせて使うことで、SQL Server データと同じようにSpark へのアクセスが可能です。 本記事では、外部データソースと外部テーブルの作成から、T-SQL クエリを使ってリアルタイムSpark のデータへ接続を認可するところまで説明します。

CData ODBC ドライバーは、ドライバーに組み込まれた最適化されたデータ処理により、PolyBase でリアルタイムSpark のデータを送受信するための圧倒的なパフォーマンスを提供します。SQL Server からSpark に複雑なSQL クエリを発行すると、ドライバーはフィルタや集計などのサポートされているSQL 操作をSpark に直接プッシュダウンし、組み込みSQL エンジンを利用して、サポートされていない操作(一般的にはSQL 関数とJOIN 操作) をクライアント側で処理します。また、PolyBase を使用することで、単一のクエリを使用して分散ソースからデータをプルし、SQL Server データをSpark と結合することもできます。

CData ODBC ドライバとは?

CData ODBC ドライバは、以下のような特徴を持ったリアルタイムデータ連携ソリューションです。

- Spark をはじめとする、CRM、MA、会計ツールなど多様なカテゴリの270種類以上のSaaS / オンプレミスデータソースに対応

- 多様なアプリケーション、ツールにSpark のデータを連携

- ノーコードでの手軽な接続設定

- 標準 SQL での柔軟なデータ読み込み・書き込み

CData ODBC ドライバでは、1.データソースとしてSpark の接続を設定、2.PolyBase 側でODBC Driver との接続を設定、という2つのステップだけでデータソースに接続できます。以下に具体的な設定手順を説明します。

CData ODBC ドライバのインストールとSpark への接続設定

まずは、本記事右側のサイドバーからSparkSQL ODBC Driver の無償トライアルをダウンロード・インストールしてください。30日間無償で、製品版の全機能が使用できます。

未指定の場合は、初めにODBC DSN(data source name)で接続プロパティを指定します。ドライバーのインストールの最後にアドミニストレーターが開きます。Microsoft ODBC Data Source Administrator を使用して、ODBC DSN を作成および構成できます。PolyBase を使用してSQL Server に外部データソースを作成するには、System DSN を構成します。(CData Spark Sys は自動的に作成されます。)

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

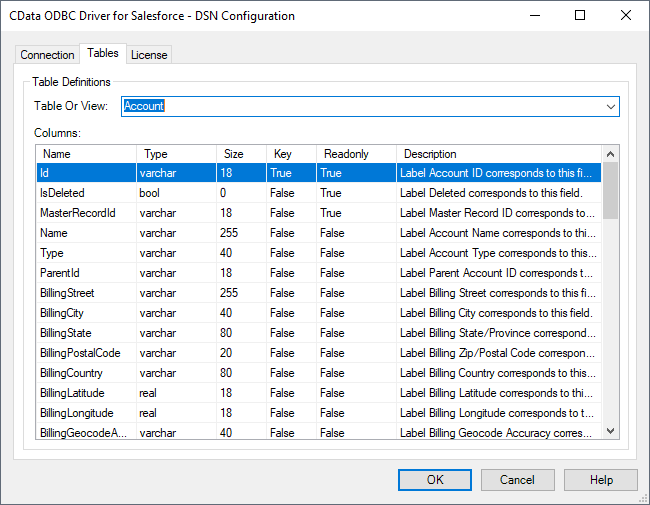

[接続のテスト]をクリックして、DSN がSpark に正しく接続できているかを確認します。[テーブル]タブに移動し、Spark のテーブル定義を確認します。

Spark のデータの外部データソースを作成

接続を構成したのち、外部データソースのマスター暗号化キーと資格情報データベースを作成する必要があります。

マスター暗号化キーの作成

以下のSQL コマンドを実行して新しいマスターキー[ENCRYPTION]を作成し、外部データソースの資格情報を暗号化します。

CREATE MASTER KEY ENCRYPTION BY PASSWORD = 'password';

資格情報データベースの作成

以下のSQL コマンドを実行してSpark に接続されている外部データソースの資格情報を作成します。

Note:Spark は認証にUser やPassword を必要としないため、IDENTITY とSECRET に任意の値を使用できます。

CREATE DATABASE SCOPED CREDENTIAL sparksql_creds WITH IDENTITY = 'username', SECRET = 'password';

Spark の外部データソースを作成

以下のSQL コマンドを実行し、以前作成したDSN と資格情報を使用して、PolyBase でSpark の外部データソースを作成します。

PUSHDOWN は、デフォルトでON に設定されているため、ODBC Driver は、サーバー側の処理を利用して複雑なクエリを実行できます。

CREATE EXTERNAL DATA SOURCE cdata_sparksql_source WITH ( LOCATION = 'odbc://SERVERNAME[:PORT]', CONNECTION_OPTIONS = 'DSN=CData Spark Sys', -- PUSHDOWN = ON | OFF, CREDENTIAL = sparksql_creds );

Spark の外部テーブルを作成

外部データソースを作成したら、CREATE EXTERNAL TABLE ステートメントを使用してSQL Server インスタンスからSpark にリンクします。テーブルカラムの定義は、CData ODBC Driver for SparkSQL によって公開されているものと一致しなければなりません。DSN Configuration Wizard の[テーブル]タブを参照し、テーブルの定義を確認できます。

CREATE TABLE ステートメントのサンプル

以下は、Spark Customers に基づいて外部テーブルを作成するステートメントの一例です。

CREATE EXTERNAL TABLE Customers( City [nvarchar](255) NULL, Balance [nvarchar](255) NULL, ... ) WITH ( LOCATION='Customers', DATA_SOURCE=cdata_sparksql_source );

SQL Server インスタンスでSpark の外部テーブルを作成すると、ローカルデータとリモートデータを同時にクエリできるようになります。CData ODBC Driver に組み込まれているクエリ処理により、可能な限り多くのクエリ処理がSpark にプッシュされることで、ローカルのリソースと計算リソースが解放されます。ODBC Driver for SparkSQL の30日間無料トライアルをダウンロードし、SQL Server データでリアルタイムSpark のデータを使い始めましょう。

Spark からPolyBase へのデータ連携には、ぜひCData ODBC ドライバをご利用ください

このようにCData ODBC ドライバと併用することで、270を超えるSaaS、NoSQL データをコーディングなしで扱うことができます。30日の無償評価版が利用できますので、ぜひ自社で使っているクラウドサービスやNoSQL と合わせて活用してみてください。

CData ODBC ドライバは日本のユーザー向けに、UI の日本語化、ドキュメントの日本語化、日本語でのテクニカルサポートを提供しています。