各製品の資料を入手。

詳細はこちら →Python pandas を使ってAzure Data Lake Storage のデータを可視化・分析する方法

CData Python Connector を使えば、Python でAzure Data Lake Storage をpandas などのライブラリで呼び出してデータ分析や可視化を実行できます。

最終更新日:2023-09-23

この記事で実現できるAzure Data Lake Storage 連携のシナリオ

こんにちは!ウェブ担当の加藤です。マーケ関連のデータ分析や整備もやっています。

Python エコシステムには多くのライブラリがあり、開発やデータ分析を行う際には必須と言っていいライブラリも多く存在します。CData Python Connector for ADLS は、pandas、Matplotlib、SQLAlchemy から使用することで Azure Data Lake Storage にデータ連携するPython アプリケーションを構築したり、Azure Data Lake Storage のデータの可視化を実現します。本記事では、pandas、SQLAlchemy、およびMatplotlib のビルトイン機能でAzure Data Lake Storage にリアルタイムアクセスし、クエリを実行して結果を可視化する方法を説明します。

CData Python Connectors の特徴

CData Python Connectors は、以下のような特徴を持った製品です。

- Azure Data Lake Storage をはじめとする、CRM、MA、会計ツールなど多様なカテゴリの270種類以上のSaaS / オンプレデータソースに対応

- pandas をはじめとする多様なデータ分析・BI ツールにAzure Data Lake Storage のデータを連携

- ノーコードでの手軽な接続設定

CData Python Connectors では、1.データソースとしてAzure Data Lake Storage の接続を設定、2.Python からPython Connectors との接続を設定、という2つのステップだけでデータソースに接続できます。以下に具体的な設定手順を説明します。

以下の手順に従い、必要なライブラリをインストールし、Python オブジェクト経由でAzure Data Lake Storage にアクセスします。

必要なライブラリのインストール

pip で、pandas & Matplotlib ライブラリおよび、SQLAlchemy をインストールします。

pip install pandas pip install matplotlib pip install sqlalchemy

次にライブラリをインポートします。

import pandas import matplotlib.pyplot as plt from sqlalchemy import create_engine

Python でAzure Data Lake Storage のデータを可視化

次は接続文字列を作成してAzure Data Lake Storage に接続します。create_engine 関数を使って、Azure Data Lake Storage に連携するEngne を作成します。以下はサンプルの接続文字列になりますので、環境に応じてクレデンシャル部分を変更してください。

engine = create_engine("adls:///?Schema=ADLSGen2&Account=myAccount&FileSystem=myFileSystem&AccessKey=myAccessKey&InitiateOAuth=GETANDREFRESH&OAuthSettingsLocation=/PATH/TO/OAuthSettings.txt")

Azure Data Lake Storage 接続プロパティの取得・設定方法

Azure Data Lake Storage Gen 2 への接続

Gen 2 Data Lake Storage アカウントに接続するには、以下のプロパティを設定します。

- Account:ストレージアカウントの名前。

- FileSystem:このアカウントに使用されるファイルシステム名。例えば、Azure Blob コンテナの名前。

- Directory(オプション):レプリケートされたファイルが保存される場所へのパス。パスが指定されない場合、ファイルはルートディレクトリに保存されます。

Azure Data Lake Storage Gen 2 への認証

本製品は、次の4つの認証方法をサポートします:アクセスキーの使用、共有アクセス署名の使用、Azure Active Directory OAuth(AzureAD)、Managed Service Identity(AzureMSI)。

アクセスキー

アクセスキーを使用して接続するには、はじめにADLS Gen2 ストレージアカウントで利用可能なアクセスキーを取得する必要があります。Azure ポータルで:

- ADLS Gen2 ストレージアカウントにアクセスします。

- 設定でアクセスキーを選択します。

- 利用可能なアクセスキーの1つの値をAccessKey 接続プロパティにコピーします。

- AuthScheme:AccessKey。

- AccessKey:先にAzure ポータルで取得したアクセスキーの値。

接続の準備ができたら、次のプロパティを設定します。

共有アクセス署名(SAS)

共有アクセス署名を使用して接続するには、はじめにAzure Storage Explorer ツールを使用して署名を生成する必要があります。

接続の準備ができたら、次のプロパティを設定します。

- AuthScheme:SAS。

- SharedAccessSignature:先に生成した共有アクセス署名の値。

AzureAD、AzureMSI での認証方法については、ヘルプドキュメントの「Azure Data Lake Storage Gen 2 への認証」セクションを参照してください。

Azure Data Lake Storage にアクセスするSQL を実行

pandas のread_sql 関数を使って好きなSQL を発行して、DataFrame にデータを格納します。

df = pandas.read_sql("""SELECT FullPath, Permission FROM Resources WHERE Type = 'FILE'""", engine)

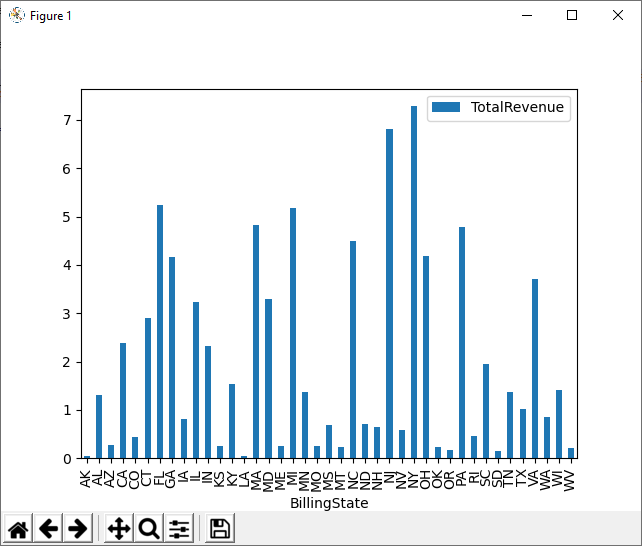

Azure Data Lake Storage のデータを可視化

DataFrame に格納されたクエリ結果に対して、plot 関数をつかって、Azure Data Lake Storage のデータをグラフ化してみます。

df.plot(kind="bar", x="FullPath", y="Permission") plt.show()

Azure Data Lake Storage からPython へのデータ連携には、ぜひCData Python Connector をご利用ください

このようにCData Python Connector と併用することで、270を超えるSaaS、NoSQL データをPython からコーディングなしで扱うことができます。30日の無償評価版が利用できますので、ぜひ自社で使っているクラウドサービスやNoSQL と合わせて活用してみてください。

日本のユーザー向けにCData Python Connector は、UI の日本語化、ドキュメントの日本語化、日本語でのテクニカルサポートを提供しています。

ソースコード

import pandas

import matplotlib.pyplot as plt

from sqlalchemy import create_engin

engine = create_engine("adls:///?Schema=ADLSGen2&Account=myAccount&FileSystem=myFileSystem&AccessKey=myAccessKey&InitiateOAuth=GETANDREFRESH&OAuthSettingsLocation=/PATH/TO/OAuthSettings.txt")

df = pandas.read_sql("""SELECT FullPath, Permission FROM Resources WHERE Type = 'FILE'""", engine)

df.plot(kind="bar", x="FullPath", y="Permission")

plt.show()