各製品の資料を入手。

詳細はこちら →Elasticsearch へLogstash 経由でAccess のデータをロードする方法

全文検索サービスElasticsearch のETL モジュール「Logstash」とCData JDBC ドライバを使って、Access のデータを簡単にロードする方法をご紹介。

最終更新日:2022-07-22

この記事で実現できるAccess 連携のシナリオ

こんにちは!ウェブ担当の加藤です。マーケ関連のデータ分析や整備もやっています。

Elasticsearch は、人気の分散型全文検索エンジンです。データを一元的に格納することで、超高速検索や、関連性の細かな調整、パワフルな分析が大規模に、手軽に実行可能になります。Elasticsearch にはデータのローディングを行うパイプラインツール「Logstash」があります。CData Drivers を利用することができるので、30日の無償評価版をダウンロードしてあらゆるデータソースを簡単にElasticsearch に取り込んで検索・分析を行うことができます。

この記事では、CData Driver for Access を使って、Access のデータをLogstash 経由でElasticsearch にロードする手順を説明します。

Elasticsearch Logstash でCData JDBC Driver for Access を使用

- CData JDBC Driver for Access をLogstash が稼働するマシンにインストールします。

-

以下のパスにJDBC Driver がインストールされます(2022J の部分はご利用される製品バージョンによって異なります)。後ほどこのパスを使います。この.jar ファイル(製品版の場合は.lic ファイルも)をLogstash に配置します。

C:\Program Files\CData\CData JDBC Driver for Access 2022J\lib\cdata.jdbc.access.jar

- 次に、Logstash とCData JDBC ドライバをつなぐ、JDBC Input Plugin をインストールします。JDBC Plugin は最新のLogstash だとデフォルトでついてきますが、バージョンによっては追加する必要があります。

https://www.elastic.co/guide/en/logstash/5.4/plugins-inputs-jdbc.html - CData JDBC ドライバの.jar ファイルと.lic ファイルを、Logstashの「/logstash-core/lib/jars/」に移動します。

Logstash でElasticsearch にAccess のデータを送る

それでは、Logstash でElasticsearch にAccess のデータの転送を行うための設定ファイルを作成していきます。

- Logstash のデータ処理定義であるlogstash.conf ファイルにAccess のデータを取得する処理を書きます。Input はJDBC、Output はElasticsearch にします。データローディングジョブの起動間隔は30秒に設定しています。

- CData JDBC ドライバの.jar をjdbc driver ライブラリにして、クラス名を設定、Access への接続プロパティをJDBC URL の形でせっていします。JDBC URL ではほかにも詳細な設定を行うことができるので、細かくは製品ドキュメントをご覧ください。

Access接続の設定方法

ローカルファイルへの接続設定

ローカル環境からAccess への接続は非常にシンプルです。ConnectionType をLocal に設定することで、CRUD 操作(SELECT、INSERT、UPDATE、DELETE)をすべて実行できます。接続にはDataSource プロパティに以下のようなAcces sデータベースファイルのフルパスを指定します。

C:\Users\Public\Documents\MyDatabase.accdb

詳細な接続手順については、ヘルプドキュメントの「はじめに」セクションをご参照ください。

クラウドストレージ上のAccess ファイルへの接続設定

各種クラウドストレージに保存されているAccess ファイルへのアクセスにも対応しています。ただし、クラウド上のファイルに対するデータ操作は、INSERT、UPDATE、DELETE に制限されますのでご注意ください。

S3、Google Driver、OneDrive など、各種クラウドストレージ内のAccess ファイルへの接続方法はこちらの記事をご確認ください。

クラウド上のファイルを更新したい場合は、以下の手順で実施いただけます。

- 対応するCData ドライバーを利用し、クラウドサービスからAccess ファイルをダウンロード

- Access ドライバーを使用して、ローカル環境でファイルを編集

- クラウドサービス用ドライバーのストアドプロシージャを使用して、更新ファイルをアップロード

具体例として、SharePoint 上のファイルを更新する場合の手順をご紹介します。

- CData SharePoint ドライバーのDownloadDocument プロシージャを使用してファイルを取得

- CData Access ドライバーでファイルの更新を実施

- SharePoint ドライバーのUploadDocument プロシージャで更新内容を反映

DataSource 接続プロパティの設定について補足いたします。接続先のクラウドストレージを識別するための一意の接頭辞を指定し、続けて目的のファイルパスまたはフォルダパスを記述します。フォルダを指定した場合は1ファイルが1テーブルとして、単一ファイルの場合は単一テーブルとして扱われます。

input {

jdbc {

jdbc_driver_library => "../logstash-core/lib/jars/cdata.jdbc.access.jar"

jdbc_driver_class => "Java::cdata.jdbc.access.AccessDriver"

jdbc_connection_string => "jdbc:access:DataSource=C:/MyDB.accdb;"

jdbc_user => ""

jdbc_password => ""

schedule => "*/30 * * * * *"

statement => "SELECT Orders.Freight, Customers.ContactName FROM Customers INNER JOIN Orders ON Customers.CustomerId=Orders.CustomerId"

}

}

output {

Elasticsearch {

index => "access_Orders"

document_id => "xxxx"

}

}

Logstash でAccess のローディングを実行

それでは作成した「logstash.conf」ファイルを元にLogstash を実行してみます。

> logstash-7.8.0\bin\logstash -f logstash.conf

成功した旨のログが出ます。これでAccess のデータがElasticsearch にロードされました。

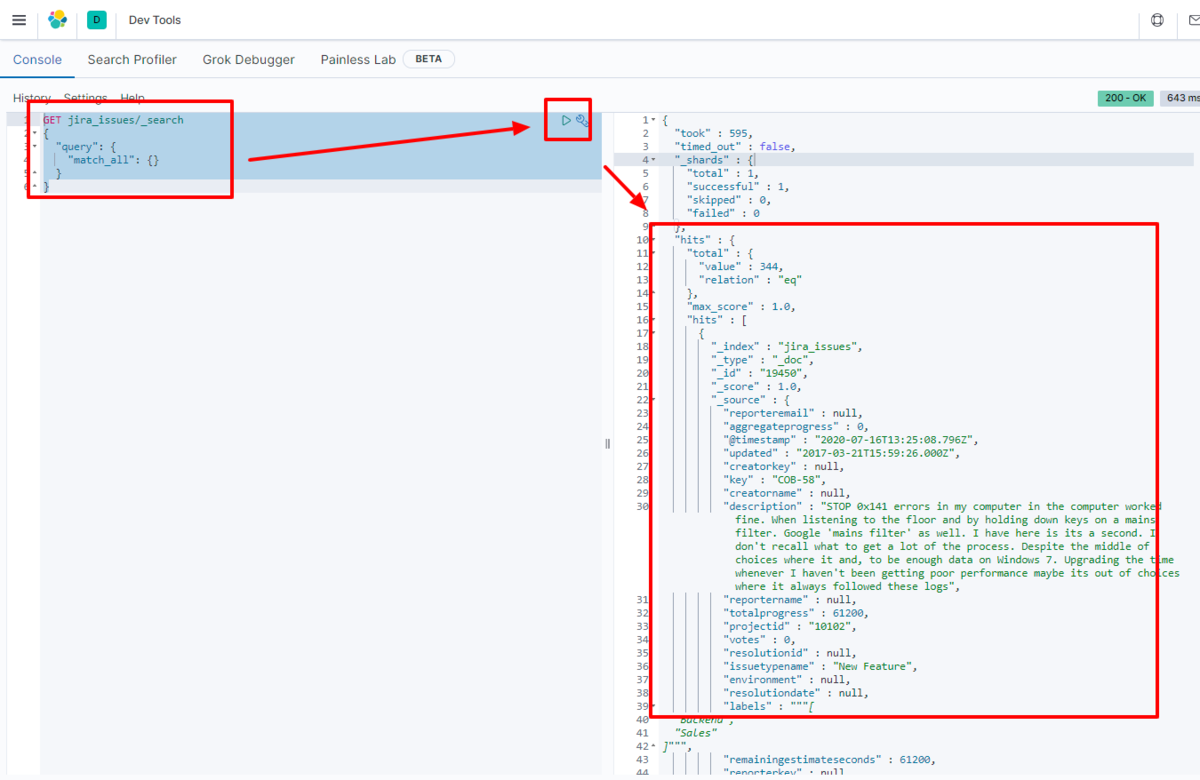

例えばKibana で実際にElasticsearch に転送されたデータを見てみます。

GET access_Orders/_search

{

"query": {

"match_all": {}

}

}

データがElasticsearch に格納されていることが確認できました。

CData JDBC Driver for Access をLogstash で使うことで、Access コネクタとして機能し、簡単にデータをElasticsearch にロードすることができました。ぜひ、30日の無償評価版をお試しください。